Įvadas: besivystantis NLP kūrimo kraštovaizdis

Praėjusiais metais NLP technologija pažengė į priekį – nuo efektyvesnių koregavimo metodų iki multimodalinių galimybių, sujungiančių tekstą su kitų tipų duomenimis. Veiklos efektyvumas tampa vis svarbesnis, nes vis daugiau NLP darbo krūvių pereina į kraštutinius įrenginius ir vartotojų aparatinę įrangą. Tuo tarpu specializuotos domeno galimybės išsiplėtė, kad aptarnautų pramonės šakas nuo sveikatos priežiūros iki teisinių paslaugų precedento neturinčiu tikslumu.

Nesvarbu, ar kuriate pokalbio agentą, analizuojate klientų atsiliepimus, semiatės įžvalgų iš dokumentų ar kuriate turinio generavimo įrankius, tinkamos NLP bibliotekos pasirinkimas gali labai paveikti jūsų projekto sėkmę. Šiame vadove nagrinėjamos septynios įtakingiausios 2025 m. NLP bibliotekos, lyginamos jų stipriosios pusės, trūkumai ir idealūs naudojimo atvejai, siekiant padėti priimti pagrįstą sprendimą dėl kito plėtros projekto.

1. Hugging Face Transformers 6.0: visapusiška ekosistema

Pagrindinės savybės ir patobulinimai

Naujausioje versijoje įdiegtos kelios žaidimą keičiančios funkcijos:

Veiksminga koregavimo sistema: naujasis EFT modulis žymiai sumažina skaičiavimo reikalavimus pritaikant pagrindų modelius konkrečioms užduotims. Modelius, kuriems anksčiau reikėjo kelių grafikos procesorių koregavimui, dabar galima pritaikyti vartotojų aparatinei įrangai su minimaliais našumo kompromisais.

Multimodaliniai vamzdynai: „Transformers“ dabar siūlo supaprastintus vamzdynus, skirtus programoms kurti, kurios sklandžiai derina teksto analizę su vaizdo, garso ir net vaizdo supratimu – puikiai tinka kuriant labiau kontekstą atitinkančias programas.

Įmonių lygio diegimo įrankiai: naujas diegimo įrankių rinkinys supaprastina modelių perkėlimą iš tyrimų į gamybą, automatizuodamas optimizavimą įvairiems aparatūros tikslams, nuo serverių grupių iki mobiliųjų įrenginių.

Domeno specializacijos paketai: iš anksto sukonfigūruoti nustatymai ir modeliai konkrečioms pramonės šakoms, pvz., sveikatos priežiūrai, teisinei ir finansams, leidžia kūrėjams pradėti nuo domenui optimizuotų pagrindų, o ne bendrų modelių.

Kodėl kūrėjams tai patinka

Transformatoriai ir toliau dominuoja, nes sukuria išskirtinę pusiausvyrą tarp prieinamumo ir pažangiausių galimybių. Dėl gerai dokumentuotos API naujokams lengva įdiegti pažangias NLP funkcijas, o plačios tinkinimo parinktys patenkina patyrusių ML inžinierių poreikius.

Gyvybinga bendruomenė, supanti Hugging Face, taip pat reiškia, kad dažniausiai pasitaikančių problemų sprendimus tereikia paieškoti forume, o tai žymiai sumažina kūrimo laiką. Dabar modelių centre yra daugiau nei 75 000 iš anksto paruoštų modelių, todėl kūrėjai dažnai gali rasti specializuotų modelių, kurie labai atitinka jų naudojimo atvejo reikalavimus, nepradėdami nuo nulio.

Idealūs naudojimo atvejai

Hugging Face Transformers 6.0 puikiai tinka:

Tyrimų projektai, reikalaujantys greito eksperimentavimo su skirtingomis modelių architektūromis

Gamybos programos, kurioms reikalingas naujausias kalbos supratimas

Komandos, norinčios panaudoti bendruomenės žinias ir išteklius

Projektai, kuriems reikalingos specialios srities žinios (sveikatos priežiūra, teisė, finansai)

Programos, kurioms reikalingos daugiarūšės galimybės

Svarstymai

Nors „Transformeriai“ išlieka universaliausia parinktis, tai ne visada efektyviausias išteklius naudojantis diegimo pasirinkimas. Kai kurie kūrėjai praneša, kad apibendrinta architektūra sukuria pridėtines išlaidas, kurių specializuotos bibliotekos vengia. Be to, sparčiai besivystanti kodų bazė reiškia, kad retkarčiais nutrūksta pagrindinių versijų pakeitimai.

2. SpaCy 4.0: gamybai paruoštas efektyvumas

Pagrindinės savybės ir patobulinimai

„SpaCy 4.0“ pateikia reikšmingų lentelės patobulinimų:

Transformatoriaus integravimas: Atnaujinti transformatoriaus dujotiekio komponentai dabar savaime veikia su naujausiais modeliais, išlaikant efektyvią „SpaCy“ apdorojimo architektūrą.

Patobulintas daugialypis apdorojimas: naujos lygiagretaus apdorojimo galimybės užtikrina beveik tiesinį dokumentų apdorojimo užduočių mastelį, todėl „SpaCy“ tinka didžiulių teksto rinkinių paketiniam apdorojimui.

Išplėstas struktūrinis numatymas: be įvardytų objektų atpažinimo ir priklausomybės analizavimo, „SpaCy“ dabar siūlo patobulintą tinkintų struktūrinių numatymo užduočių palaikymą, naudodamas lankstesnę anotaciją ir mokymo sistemą.

Paprastesni veikimo laiko reikalavimai: nepaisant didesnių galimybių, pagrindiniai apdorojimo vamzdynai dabar gali veikti su žymiai mažesniu atminties kiekiu – tai labai svarbu diegiant ribotose resursų aplinkose.

Patobulintas taisyklių variklis: modelių atitikimo sistema buvo visiškai atnaujinta, siūlant galingesnes išraiškas ir padidinant atitikimo greitį iki 300%.

Kodėl kūrėjai tai pasirenka

„SpaCy“ ir toliau yra pageidaujamas pasirinkimas gamybinėms sistemoms, nes jis užtikrina pramoninį efektyvumą su kūrėjams patogia API. Dėl apgalvotai sukurtos į objektą orientuotos architektūros ją lengva integruoti į didesnes programas, išlaikant nuoseklų veikimą.

Naujoji „SpaCy Projects“ sistema taip pat supaprastino galutinių NLP vamzdynų pakavimą ir diegimą, todėl komandos gali standartizuoti savo kūrimo darbo eigą nuo eksperimentavimo iki gamybos.

Idealūs naudojimo atvejai

SpaCy 4.0 puikiai tinka:

Didelio našumo teksto apdorojimo sistemos

Gamybos aplinka, kurioje patikimumas ir nuspėjamumas yra labai svarbūs

Programos, kurioms reikalingas pramoninio stiprumo pavadintų objektų atpažinimas ir ryšių ištraukimas

Projektai su diegimo apribojimais (atmintis, apdorojimo galia)

Komandos, kurioms reikalingos ir klasikinės NLP galimybės, ir šiuolaikiniai neuroniniai metodai

Svarstymai

Nors „SpaCy“ padarė didelę pažangą įtraukdama transformatorių modelius, ji vis dar nepasiūlo tokio paties pažangiausių tyrimų įgyvendinimo galimybių kaip „Hugging Face“. Be to, kai kurie kūrėjai mano, kad jo nuomone, architektūra yra mažiau lanksti labai pritaikytoms mokslinių tyrimų programoms.

3. Cohere SDK: API-pirmosios kalbos intelektas

Pagrindinės savybės ir patobulinimai

„Cohere“ platforma siūlo keletą patrauklių galimybių:

Command ir Command-R modeliai: šie modeliai puikiai seka konkrečias instrukcijas ir supranta niuansuotas užklausas, todėl puikiai tinka kurti įrankius, kurie tiksliai reaguoja į vartotojo užklausas.

Įterpti modeliai: naujausios kartos įterpimo modeliai sukuria nepaprastai tikslius semantinius vaizdus, žymiai pralenkdami ankstesnius paieškos ir klasifikavimo metodus.

Įmonės pritaikymas: organizacijoms, turinčioms specifinių poreikių, „Cohere“ dabar siūlo tinkinimo parinktis, kurios pritaiko pagrindinius modelius specializuotoms sritims, nereikalaujant didžiulių mokymo duomenų rinkinių.

Daugiakalbių kalbų palaikymas: 100 ir daugiau kalbų teikiamos tvirtos galimybės leidžia naudoti pasaulines programas, nereikalaujant atskirų modelių kiekvienai kalbai.

Atsakingi dirbtinio intelekto valdikliai: integruoti saugos filtrai ir šališkumo aptikimas padeda kūrėjams kurti sistemas, atitinkančias vis svarbesnius etikos standartus.

Kodėl kūrėjai tai pasirenka

„Cohere SDK“ įgijo trauką pirmiausia dėl to, kad žymiai sumažina kliūtis diegti sudėtingas NLP galimybes. Kūrėjai, neturintys mašininio mokymosi patirties, gali pridėti pažangų kalbos supratimą prie programų su minimaliu kodu, o prireikus vis tiek tiksliai valdydami modelio elgesį.

Pirmojo API metodas taip pat reiškia, kad komandoms nereikia jaudintis dėl infrastruktūros valdymo ar naujausių mokslinių tyrimų pasiekimų – „Cohere“ tvarko šiuos aspektus, todėl kūrėjai gali sutelkti dėmesį į savo programų logiką.

Idealūs naudojimo atvejai

„Cohere SDK“ puikiai tinka:

Startuoliai ir komandos, neturinčios specialios ML infrastruktūros

Programos, kurių mastelį reikia greitai keisti nevaldant modelio diegimo

Projektai, kuriems reikalingas įmonės lygio patikimumas ir palaikymas

Kelių kalbų programos, aptarnaujančios pasaulines rinkas

Naudokite atvejus, kai atsakingai dirbtinio intelekto veiklai teikiama pirmenybė

Svarstymai

Pagrindinis „Cohere“ kompromisas yra tas, kad kūrėjai priklauso nuo trečiosios šalies paslaugos, o ne naudoja modelius savo infrastruktūroje. Tai gali sukelti susirūpinimą dėl duomenų privatumo, paslaugų prieinamumo ir ilgalaikio kainų stabilumo. Kai kurie kūrėjai taip pat pažymi, kad API pagrįstas metodas, nors ir patogus, kartais riboja lankstumą, palyginti su tiesiogine prieiga prie modelio vidinių elementų.

4. PyTorch NLP (torchtext 3.0): tyrėjo pasirinkimas

Pagrindinės savybės ir patobulinimai

Naujausioje versijoje yra keletas svarbių atnaujinimų:

Vietinis transformatorių architektūrų palaikymas: aukščiausios klasės dėmesio mechanizmų ir transformatorių blokų diegimas leidžia lengviau įdiegti pasirinktines architektūras.

Optimizuoti duomenų apdorojimo vamzdynai: naujos vektorinio teksto apdorojimo operacijos efektyviau išnaudoja šiuolaikinius procesorius ir GPU, žymiai pagreitindamos išankstinio apdorojimo veiksmus.

Patobulinta perkėlimo mokymosi sistema: patobulinta API leidžia lengvai pritaikyti iš anksto paruoštus modelius naujoms užduotims, išlaikant tikslią mokymo proceso kontrolę.

Kvantifikavimo ir genėjimo įrankiai: Integruotos modelio glaudinimo galimybės leidžia tyrėjams sumažinti modelio dydį ir išvados laiką be per didelio našumo pablogėjimo.

Patobulintas paketinis apdorojimas: išmanesnės kintamo ilgio sekų paketavimo strategijos leidžia efektyviau naudoti GPU treniruočių metu.

Kodėl mokslininkai ir kūrėjai pasirenka jį

„PyTorch NLP“ išlieka pirmenybė teikiama moksliniams tyrimams ir specializuotoms programoms, nes suteikia maksimalų lankstumą neprarandant naudojimo patogumo. Būtinas programavimo stilius atitinka daugelio kūrėjų mąstymą, todėl lengviau derinti modelius ir eksperimentuoti su naujais metodais.

Sklandi integracija su platesne PyTorch ekosistema taip pat reiškia, kad bendrojo gilaus mokymosi pažanga (pvz., optimizavimo metodai ar mokymo metodai) yra nedelsiant pritaikyti NLP užduotims.

Idealūs naudojimo atvejai

PyTorch NLP geriausiai tinka:

Tyrimų projektai, kuriuose nagrinėjamos naujos architektūros arba mokymo metodai

Programos, kurioms reikalingas pritaikytas modelio veikimas, nepasiekiamos aukštesnio lygio bibliotekose

Švietimo kontekstai, kuriuose svarbu suprasti modelio vidines savybes

Projektai, kuriuose reikalinga integracija su kompiuterine vizija ar kitais būdais

Situacijos, kai reikia maksimaliai kontroliuoti treniruočių procesą

Svarstymai

PyTorch NLP lankstumas yra staigesnis mokymosi kreivė ir didesnė atsakomybė už įgyvendinimą. Kūrėjai turi priimti daugiau architektūrinių sprendimų ir įdiegti daugiau komponentų nuo nulio, palyginti su aukštesnio lygio bibliotekomis. Be to, norint tinkamai įdiegti kai kurias gamybos optimizavimo funkcijas, reikia papildomo darbo.

5. JAX NLP (FLAX/Prax): našumas dideliu mastu

Meta Description: Discover the most powerful and versatile natural language processing libraries of 2025 that are revolutionizing how developers build intelligent text applications.

Introduction: The Evolving Landscape of NLP Development

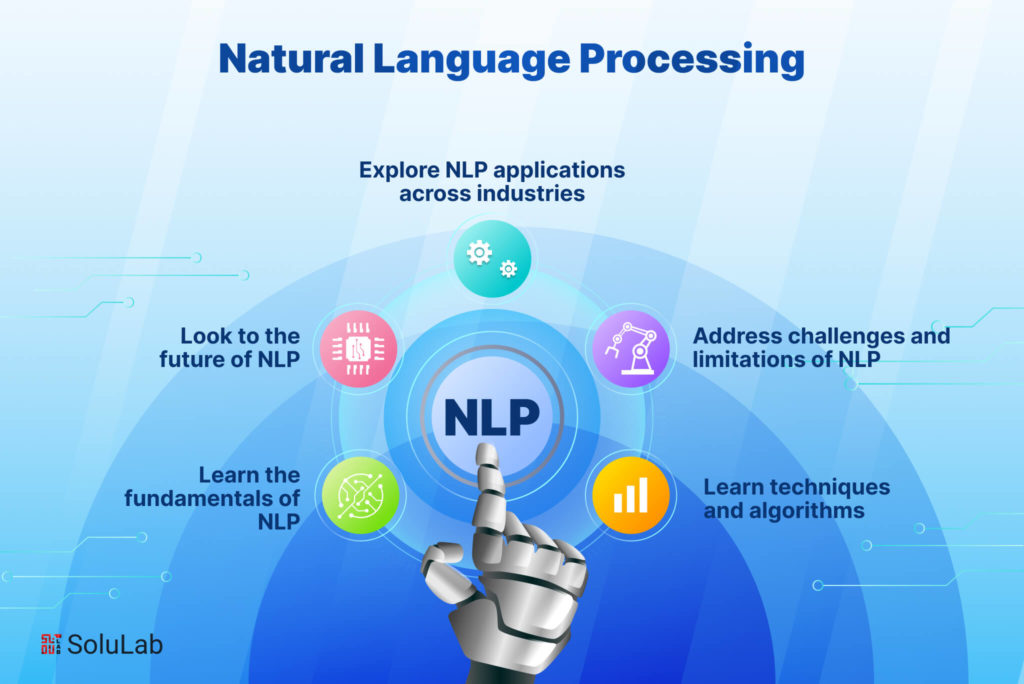

Natural Language Processing (NLP) continues to transform how we interact with technology in 2025. As the demand for sophisticated language understanding capabilities grows across industries, developers need powerful, efficient, and accessible tools to build applications that can genuinely understand and generate human language.

The past year has seen remarkable advancements in NLP technology—from more efficient fine-tuning approaches to multimodal capabilities that bridge text with other data types. Runtime efficiency has become increasingly important as more NLP workloads move to edge devices and consumer hardware. Meanwhile, specialized domain capabilities have expanded to serve industries from healthcare to legal services with unprecedented accuracy.

Whether you're building a conversational agent, analyzing customer feedback, extracting insights from documents, or creating content generation tools, choosing the right NLP library can dramatically impact your project's success. This guide examines the seven most impactful NLP libraries of 2025, comparing their strengths, limitations, and ideal use cases to help you make an informed decision for your next development project.

1. Hugging Face Transformers 6.0: The Comprehensive Ecosystem

Hugging Face Transformers has cemented its position as the go-to library for accessing state-of-the-art NLP models, and the 6.0 release takes its capabilities to new heights. Far more than just a model repository, Transformers has evolved into a comprehensive ecosystem that covers the entire NLP development lifecycle.

Key Features and Improvements

The latest version introduces several game-changing features:

Efficient Fine-tuning Framework: The new EFT module significantly reduces the computational requirements for adapting foundation models to specific tasks. Models that previously required multiple GPUs for fine-tuning can now be customized on consumer hardware with minimal performance trade-offs.

Multimodal Pipelines: Transformers now offers streamlined pipelines for building applications that seamlessly combine text analysis with image, audio, and even video understanding—perfect for creating more context-aware applications.

Enterprise-Grade Deployment Tools: The new deployment toolkit simplifies moving models from research to production with automated optimization for different hardware targets, from server clusters to mobile devices.

Domain Specialization Packs: Pre-configured settings and models for specific industries like healthcare, legal, and finance allow developers to start with domain-optimized foundations rather than generic models.

Why Developers Love It

Transformers continues to dominate because it strikes an exceptional balance between accessibility and cutting-edge capabilities. The well-documented API makes it straightforward for newcomers to implement advanced NLP features, while the extensive customization options satisfy the needs of experienced ML engineers.

The vibrant community surrounding Hugging Face also means solutions to common problems are usually just a forum search away, significantly reducing development time. With over 75,000 pre-trained models now available in the Model Hub, developers can often find specialized models that closely match their use case requirements without starting from scratch.

Ideal Use Cases

Hugging Face Transformers 6.0 excels for:

Research projects requiring quick experimentation with different model architectures

Production applications needing state-of-the-art language understanding

Teams wanting to leverage community knowledge and resources

Projects requiring specialized domain knowledge (healthcare, legal, finance)

Applications needing multimodal capabilities

Considerations

While Transformers remains the most versatile option, it's not always the most resource-efficient choice for deployment. Some developers report that the generalized architecture introduces overhead that specialized libraries avoid. Additionally, the rapidly evolving codebase means occasional breaking changes between major versions.

2. SpaCy 4.0: Production-Ready Efficiency

SpaCy has long been the workhorse of production NLP systems, and version 4.0 reinforces this position while expanding its capabilities to incorporate transformer-based models more seamlessly than ever. The library's focus on production efficiency combined with state-of-the-art accuracy makes it ideal for systems that need reliability at scale.

Key Features and Improvements

SpaCy 4.0 brings significant enhancements to the table:

Transformer Integration: The updated transformer pipeline components now work natively with the latest models while maintaining SpaCy's efficient processing architecture.

Enhanced Multiprocessing: New parallel processing capabilities provide near-linear scaling for document processing tasks, making SpaCy suitable for batch processing enormous text collections.

Expanded Structured Prediction: Beyond named entity recognition and dependency parsing, SpaCy now offers enhanced support for custom structured prediction tasks through a more flexible annotation and training framework.

Leaner Runtime Requirements: Despite the increased capabilities, core processing pipelines can now run with significantly reduced memory footprints—crucial for deployment in resource-constrained environments.

Improved Rule Engine: The pattern matching system has been completely overhauled, offering more powerful expressions while improving match speed by up to 300%.

Why Developers Choose It

SpaCy continues to be the preferred choice for production systems because it provides industrial-strength performance with a developer-friendly API. The thoughtfully designed object-oriented architecture makes it easy to integrate into larger applications while maintaining consistent performance.

The new "SpaCy Projects" framework has also simplified the packaging and deployment of end-to-end NLP pipelines, allowing teams to standardize their development workflows from experimentation to production.

Ideal Use Cases

SpaCy 4.0 is perfect for:

High-throughput text processing systems

Production environments where reliability and predictability are crucial

Applications requiring industrial-strength named entity recognition and relation extraction

Projects with deployment constraints (memory, processing power)

Teams that need both classical NLP capabilities and modern neural approaches

Considerations

While SpaCy has made great strides in incorporating transformer models, it still doesn't offer the same breadth of cutting-edge research implementations as Hugging Face. Additionally, some developers find its opinionated architecture less flexible for highly customized research applications.

3. Cohere SDK: API-First Language Intelligence

Cohere has emerged as a powerful alternative in the NLP ecosystem with its SDK that focuses on delivering production-ready language intelligence through a streamlined API. Rather than requiring developers to manage model deployment themselves, Cohere provides access to continuously updated, state-of-the-art models via simple API calls.

Key Features and Improvements

The Cohere platform offers several compelling capabilities:

Command and Command-R Models: These models excel at following specific instructions and understanding nuanced requests, making them ideal for building tools that respond precisely to user queries.

Embed Models: The latest generation embedding models create remarkably accurate semantic representations, significantly outperforming previous approaches in retrieval and classification tasks.

Enterprise Customization: For organizations with specific needs, Cohere now offers customization options that adapt their core models to specialized domains without requiring massive training datasets.

Multilingual Support: Robust capabilities across 100+ languages enable global applications without needing separate models for each language.

Responsible AI Controls: Built-in safety filters and bias detection help developers create systems that meet increasingly important ethical standards.

Why Developers Choose It

The Cohere SDK has gained traction primarily because it dramatically lowers the barrier to implementing sophisticated NLP capabilities. Developers without machine learning expertise can add advanced language understanding to applications with minimal code, while still having fine-grained control over the model behavior when needed.

The API-first approach also means teams don't need to worry about infrastructure management or keeping up with the latest research advancements—Cohere handles these aspects, allowing developers to focus on their application logic.

Ideal Use Cases

Cohere SDK is excellent for:

Startups and teams without dedicated ML infrastructure

Applications that need to scale quickly without managing model deployment

Projects requiring enterprise-grade reliability and support

Multi-language applications serving global markets

Use cases where responsible AI practices are a priority

Considerations

The primary tradeoff with Cohere is that developers are depending on a third-party service rather than running models in their own infrastructure. This creates potential concerns around data privacy, service availability, and long-term pricing stability. Some developers also note that the API-based approach, while convenient, sometimes limits flexibility compared to having direct access to model internals.

4. PyTorch NLP (torchtext 3.0): The Researcher's Choice

For researchers and developers who prefer working closer to the metal, PyTorch's ecosystem continues to offer unparalleled flexibility. The overhauled torchtext 3.0 has evolved from a collection of utilities into a comprehensive NLP framework while maintaining the flexibility that PyTorch users value.

Key Features and Improvements

The latest version brings several significant upgrades:

Native Support for Transformer Architectures: First-class implementations of attention mechanisms and transformer blocks make it easier to implement custom architectures.

Optimized Data Processing Pipelines: New vectorized text processing operations leverage modern CPUs and GPUs more effectively, dramatically speeding up preprocessing steps.

Enhanced Transfer Learning Framework: The refined API makes it straightforward to adapt pre-trained models to new tasks while maintaining precise control over the training process.

Quantization and Pruning Tools: Built-in capabilities for model compression enable researchers to reduce model size and inference time without excessive performance degradation.

Improved Batch Processing: Smarter batching strategies for variable-length sequences result in more efficient GPU utilization during training.

Why Researchers and Developers Choose It

PyTorch NLP remains the preferred choice for research and specialized applications because it offers maximum flexibility without sacrificing usability. The imperative programming style aligns with how most developers think, making it easier to debug models and experiment with novel approaches.

The seamless integration with the broader PyTorch ecosystem also means that advancements in general deep learning (like optimization techniques or training methods) are immediately applicable to NLP tasks.

Ideal Use Cases

PyTorch NLP is best suited for:

Research projects exploring novel architectures or training approaches

Applications requiring customized model behavior not available in higher-level libraries

Educational contexts where understanding model internals is important

Projects where integration with computer vision or other modalities is needed

Situations requiring maximal control over the training process

Considerations

The flexibility of PyTorch NLP comes with a steeper learning curve and more implementation responsibility. Developers need to make more architectural decisions and implement more components from scratch compared to higher-level libraries. Additionally, some production optimization features require additional work to implement properly.

5. JAX NLP (FLAX/Prax): Performance at Scale

JAX has established itself as the framework of choice for training and deploying extremely large language models, and its NLP ecosystem has matured significantly. The FLAX and Prax libraries built on JAX offer unprecedented performance for large-scale NLP workloads while maintaining a reasonable developer experience.

Key Features and Improvements

JAX's NLP ecosystem offers several distinctive advantages:

Transparent XLA Compilation: Automatic optimization for TPUs, GPUs, and specialized hardware delivers remarkable training and inference speed improvements.

Functional Programming Model: The pure functional approach simplifies distribution across multiple devices and helps avoid subtle training bugs.

Advanced Parallelism: Built-in support for model, data, and pipeline parallelism makes training massive models more accessible.

Hardware-Specific Optimizations: Specialized implementations take full advantage of the latest accelerator features from different hardware vendors.

Differential Privacy Integration: Built-in support for private training methods addresses growing regulatory requirements around data privacy.

Why Teams Choose It

Organizations working with extremely large models or datasets choose JAX-based solutions primarily for the performance benefits. Models that would take weeks to train on other frameworks can often be completed in days with JAX, representing significant cost savings in cloud compute resources.

The functional approach also brings benefits for reproducibility and debugging, which become increasingly important as models grow in complexity and training runs become more expensive.

Ideal Use Cases

JAX NLP is ideal for:

Training and deploying very large language models

Organizations with access to specialized hardware (TPUs, etc.)

Projects requiring maximum computational efficiency

Situations where reproducibility is critical

Applications demanding rigorous privacy guarantees

Considerations

JAX's programming model, while powerful, represents a significant departure from the more familiar object-oriented approaches of other frameworks. This can increase the initial learning curve, particularly for developers without a strong functional programming background. Additionally, while the ecosystem is growing rapidly, it still has fewer ready-to-use components than more established frameworks.

6. „TensorFlow Text 3.0“: įmonės stabilumas

Pagrindinės savybės ir patobulinimai

TensorFlow Text 3.0 pateikia keletą svarbių patobulinimų:

Integracija su TF Extended: sklandus ryšys su TensorFlow gamybos ML dujotiekio įrankiais supaprastina kelionę nuo eksperimentavimo iki diegimo.

Patobulintas TFLite palaikymas: patobulintos teksto apdorojimo operacijos TFLite daro NLP modelių diegimą mobiliuosiuose ir kraštutiniuose įrenginiuose praktiškesnį.

Nuosekli kelių platformų patirtis: tie patys modeliai ir apdorojimo vamzdynai patikimai veikia visose mokymo ir išvadų aplinkose, nuo debesies TPU iki mobiliųjų įrenginių.

Išplėstas įmonės integravimas: įprastų įmonės duomenų šaltinių savosios jungtys supaprastina teksto apdorojimo įtraukimą į esamas darbo eigas.

Išsamios aptarnavimo parinktys: nuo TF aptarnavimo iki SavedModel iki TFLite, diegimo parinktys apima praktiškai bet kokią tikslinę aplinką.

Kodėl organizacijos tai renkasi

„TensorFlow Text“ išlieka populiarus įmonės aplinkoje, nes siūlo išsamų sprendimą nuo duomenų paruošimo iki diegimo. API stabilumas ir plačios diegimo galimybės sumažina riziką, susijusią su NLP įtraukimu į misijai svarbias programas.

Integracija su „Google“ debesies pasiūlymais taip pat suteikia tiesioginį mastelio keitimo kelią organizacijoms, kurios jau investavo į tą ekosistemą.

Idealūs naudojimo atvejai

TensorFlow Text 3.0 puikiai tinka:

Įmonės programos, kurioms reikalingas gamybos stabilumas

Mobiliojo ir krašto diegimo scenarijai

Organizacijos su esamomis TensorFlow investicijomis

Projektai, kuriems reikalingi išsamūs ML vamzdynai

Programos, kuriose būtinas diegimo lankstumas

Svarstymai

Nors „TensorFlow Text“ ir toliau prideda naujų galimybių, ji kartais atsilieka nuo kitų sistemų įgyvendindama naujausius mokslinių tyrimų pasiekimus. Be to, kai kurie kūrėjai mano, kad simbolinio programavimo modelis yra mažiau intuityvus eksperimentavimui, palyginti su privalomu PyTorch metodu.

7. Flair 2.0: NLP Šveicarijos armijos peilis

Pagrindinės savybės ir patobulinimai

„Flair 2.0“ pateikia keletą pastebimų patobulinimų:

Hibridinių įterpimų sistema: lengvai derinkite įvairių tipų įterpimus (kontekstinį, statinį, simbolių lygio), kad pasiektumėte optimalų našumą atliekant konkrečias užduotis.

Vienkartinio mokymosi galimybės: Nauji kelių kadrų mokymosi metodai suteikia stebėtinai gerų rezultatų atliekant specializuotas užduotis su minimaliais pažymėtais duomenimis.

Patobulinta dokumentų žvalgyba: patobulinti dokumentų modeliavimo metodai leidžia geriau užfiksuoti ilgalaikes priklausomybes ilguose tekstuose.

Supaprastintas koregavimas: supaprastintos darbo eigos, skirtos pritaikyti iš anksto paruoštus modelius konkrečioms sritims ar užduotims.

Lengvesni išteklių reikalavimai: dėl padidinto efektyvumo „Flair“ tinka naudoti su mažiau galinga aparatūra.

Kodėl kūrėjai tai pasirenka

„Flair“ sulaukė atsidavusių gerbėjų, nes puikiai suderina galią ir paprastumą. Biblioteka siūlo beveik naujausią našumą daugeliui įprastų NLP užduočių, tuo pačiu reikalaujant žymiai mažiau kodo ir skaičiavimo išteklių nei sunkesnėms sistemoms.

Intuityvus API dizainas taip pat daro jį prieinamą kūrėjams, kurie nėra NLP specialistai, todėl jie gali integruoti sudėtingą kalbos supratimą į savo programas su gana švelniu mokymosi kreive.

Idealūs naudojimo atvejai

Flair 2.0 geriausiai tinka:

Projektai, kuriems reikalingas puikus sekos žymėjimas (NER, POS žymėjimas)

Programos su ribotais skaičiavimo ištekliais

Komandos, ieškančios greito standartinių NLP užduočių įgyvendinimo

Scenarijai su minimaliais pažymėtais mokymo duomenimis

Specializuotos teksto klasifikavimo programos

Svarstymai

Nors „Flair“ ir toliau plečia savo galimybes, ji nesiūlo tiek modelių ir technikų, kaip didesnės sistemos, tokios kaip „Hugging Face Transformers“. Be to, kai kurie kūrėjai pastebi, kad jo dokumentacija, nors ir tobulinama, vis dar trūksta išsamių pavyzdžių, randamų labiau žinomose bibliotekose.

Išvada: tinkamos NLP bibliotekos pasirinkimas jūsų poreikiams

Hugging Face Transformers 6.0 suteikia išsamiausią ekosistemų ir modelių pasirinkimą

„SpaCy 4.0“ užtikrina pramoninį efektyvumą ir gamybos patikimumą

„Cohere SDK“ siūlo pirmiausia API patogumą su nuolat atnaujinamais modeliais

PyTorch NLP suteikia tyrėjams maksimalų lankstumą ir kontrolę

JAX NLP užtikrina neprilygstamą našumą didelio masto programoms

„TensorFlow Text 3.0“ suteikia įmonės stabilumo ir diegimo parinktis

„Flair 2.0“ sujungia įspūdingas galimybes lengvoje pakuotėje

Tinkamas pasirinkimas priklauso nuo jūsų konkrečių reikalavimų:

Norint greitai sukurti prototipus ir pasiekti naujausius modelius, Hugging Face Transformers išlieka sunkiai įveikiamas. Jei gamybos patikimumas ir efektyvumas yra pagrindiniai jūsų rūpesčiai, „SpaCy“ ir toliau tobulėja. Kai svarbiausia yra kūrimo greitis ir diegimo paprastumas, Cohere API-first metodas suteikia įtikinamų pranašumų.

Tyrėjai, kuriems reikalingas maksimalus lankstumas, vis tiek imsis „PyTorch NLP“, o organizacijoms, rengiančioms didžiulius modelius, bus naudingas JAX našumo optimizavimas. Įmonėms, vertinančioms stabilumą ir visapusiškas diegimo galimybes, „TensorFlow Text“ yra saugus pasirinkimas, o komandos, ieškančios lengvo sprendimo su įspūdingomis galimybėmis, turėtų apsvarstyti „Flair“.

Kadangi NLP technologija ir toliau vystosi nepaprastai sparčiai, būdami informuoti apie šių bibliotekų galimybes ir plėtros tendencijas, galėsite pasirinkti geriausią projektų pasirinkimą ir išlaikyti savo programas pažangiausiomis.

Koks yra jūsų kitas NLP projektas ir kuri iš šių bibliotekų galėtų puikiai tikti jūsų specifiniams poreikiams?